Il 18 dicembre dello scorso anno 2013 la Banca Centrale Americana, la Fed, annunciava la fine del suo terzo Qe (Quantitative easing) e l’inizio del relativo tapering che normalmente segue il Qe.

1. Quantitative easing e Tapering

Il 18 dicembre dello scorso anno 2013 la Banca Centrale Americana, la Fed, annunciava la fine del suo terzo Qe (Quantitative easing) e l’inizio del relativo tapering che normalmente segue il Qe.

Per Quantitative easing deve intendersi la politica monetaria messa in atto dalla Fed più volte a partire dal gennaio 2009; tale politica, mirando ad abbattere la bassa inflazione o la deflazione (inflazione negativa) ossia a creare reflazione (creare cioè un’inflazione moderata), consiste nell’immettere nel sistema nuova moneta, ossia liquidità, per destinarla all’economia reale e prevede l’acquisto di titoli di Stato USA e di bond legati ai mutui; acquisto che consente di:

a) mantenere al rialzo i prezzi e quindi al ribasso i rendimenti di tali titoli;

b) incentivare gli operatori di mercato, che vendono tali titoli alla Fed, a spostare la liquidità incassata verso investimenti su titoli più rischiosi e quindi più remunerativi come azioni o obbligazioni societarie con l’effetto di farne salire i loro prezzi.

Dall’ottobre 2012, ossia da quando ha iniziato il suo terzo Qe, la Fed ha iniettato nel sistema 85 miliardi di dollari al mese fino a dicembre 2013.

Per tapering invece deve intendersi la progressiva riduzione da parte della Fed degli stimoli monetari previsti dal Qe precedente.

Attualmente la Fed, durante questo terzo tapering, ha ridotto gli stimoli, limitandosi a iniettare nel sistema 35 miliardi di dollari al mese.

Come si è detto la Fed ha messo in atto tre Qe a partire dal gennaio 2009 e la loro durata è la seguente:

Qe1 da genn 2009 ( Ib= 2,23%; Dol/Eur= 0,72) a febb 2010 ( Ib= 3,60%; Dol/Eur= 0,73)

Qe2 da nov 2010 ( Ib= 2,62%; Dol/Eur= 0,72) a magg 2011 ( Ib= 3,28%; Dol/Eur= 0,70)

Qe3 da 0tt 2012 ( Ib= 1,62%; Dol/Eur= 0,78) a dic 2013 ( Ib= 3,04%; Dol/Eur= 0,73)

Ovviamente il tapering, che segue il proprio Qe, si pone tra la fine del proprio Qe e l’inizio del Qe successivo. Si osservi che tra parentesi è stato indicato con Ib il rendimento del bond decennale USA in percentuale e con Dol/Eur il cambio contro euro del dollaro, ossia espresso in termini di euro necessari per acquistare un dollaro, rilevati entrambi all’inizio del mese di partenza e alla fine del mese di chiusura del Qe.

Un attento lettore, proprio sulla base di quanto qui prima affermato, potrebbe rimanere sorpreso nell’osservare che, durante ogni Qe, Ib si trovi a salire anziché a scendere e la cosa in senso assoluto potrebbe sembrare inaspettata; ma non lo è nel momento in cui si venga a sapere che ogni Qe, di fatto, col suo periodo si trovi pressoché inserito nel percorso di andata della parabola del ciclo economico in cui, come mi è capitato di affermare in altre occasioni, Ib tende ovviamente a salire con le forze del mercato, sicché il Qe in tale circostanza ha svolto solo il ruolo di freno a mano contro la risalita dei tassi ossia di Ib.

Di contro Ib è fortemente sceso nei tapering successivi ai Qe, (ogni tapering si è pressoché svolto sul secondo ramo della parabola del ciclo) e oggi, dopo aver raggiunto il valore 3,04 % alla fine del dicembre 2013, alla fine del terzo Qe, staziona intorno al 2,5%; fatto questo che ci fa pensare che l’andamento di Ib sia del tutto concorde col suo andamento passato o storico, concordia che ci spingerebbe a giudicare quasi ininfluente ogni Qe messo in atto dalla Fed almeno in relazione all’obiettivo di portare al ribasso Ib ossia i tassi di rendimento a lunga.

Allora lo strumento Qe serve a quasi poco o niente, dato anche che per alcuni economisti esso non salva l’economia ma serve solo a far salire i mercati azionari?

Riteniamo che con ragionevolezza si possa contrastare il giudizio di tali economisti, qualora, anziché focalizzarci sull’effetto relativo al ribasso dei rendimenti, si sposti invece la nostra attenzione sull’effetto reflazionistico del Qe verso l’economia.

Il confronto con la crisi del ‘29-’30, quando la allora molto giovane Fed (cominciò ad operare nel 1914) non adottò simili politiche monetarie, potrebbe apparire inadeguato ma non del tutto visto che l’economia del 2008 precipitava ad una velocità molto più alta di quella del ‘29-’30 e che gli utili del DJIA nel 2008 sono stati negativi, cosa mai avvenuta nella sua storia neppure nel ‘29-’30.

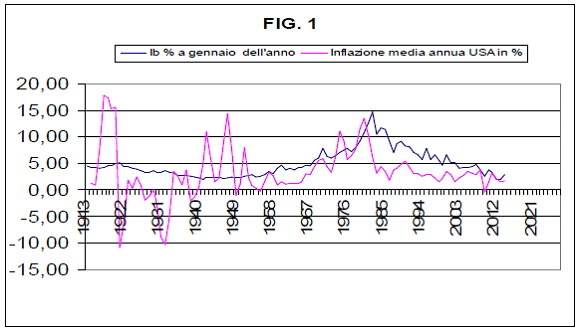

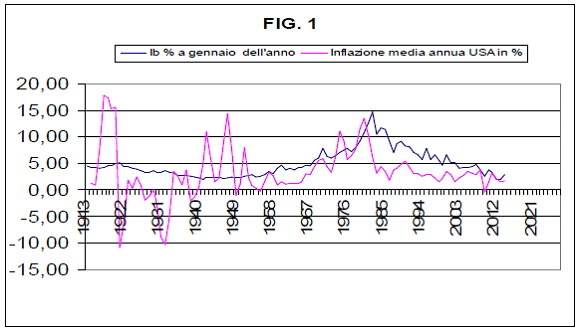

Analizziamo allora tale confronto servendoci del grafico di fig.1 qui sotto riportato; in esso è stata riportata anche l’inflazione media annua del 2014 ovviamente calcolata fino al mese di maggio e risultata pari a 1,7 %.

In tale grafico si può osservare che dal valore 0,00 % del 1929 l’inflazione media annua si è portata al valore di -10,30 % (negativo) del 1932 fino a raggiungere il primo valore positivo 3,50 % solo nel 1934; nel ’33 era ancora a -5,2% (negativo). Nella crisi attuale invece l’inflazione media annua, dopo aver raggiunto il valore negativo pari a -0,40% il 2009, si è portata subito verso l’alto facendo rilevare nei seguenti anni fino ad oggi i seguenti valori tutti positivi: 1,60%; 3,10%; 2,10%; 1,50%; 1,70%.

Ovvio quindi concludere che mentre nella crisi del ’29 la deflazione c’è stata e si è manifestata forte per un periodo persistentemente lungo, nella crisi del 2008 la deflazione è stata subito abbattuta sul nascere visto che aveva fatto appena capolino nel 2009, manifestandosi in particolar modo nel mese di luglio di quello stesso anno (-2,1%, inflazione annua in dato mensile) e poi anche continuativamente da marzo a ottobre sempre dello stesso anno.

Ma il 2009 è lo stesso anno in cui la Fed a gennaio ha lanciato il suo primo Qe e tale tempistica, anche nel ricordo di quanto accaduto nella crisi del ’29 in assenza di interventi di politica monetaria, mi induce a credere che i Qe della Fed abbiano prodotto o quantomeno contribuito a produrre l’effetto reflazionistico di cui si parlava in precedenza, effetto che ha mitigato la crisi e ridotto il rischio di una ricaduta in recessione o addirittura in deflazione dell’economia USA.

Certo la reflazione danneggia i bassi redditi, abbattendone il loro potere d’acquisto, ma sicuramente evita i danni ben peggiori che la deflazione certamente arreca all’economia e anche a chi un reddito non lo ha o è indebitato (Stati compresi).

Quando la domanda di beni e servizi scarseggia, un po’ di reflazione mitiga la crisi e consente di prendere tempo per aspettare tempi migliori senza sprofondare nel pantano della deflazione. Può addirittura anche accadere, come nel caso dell’economia USA a partire dal 2009, quindi in presenza degli stimoli monetari di cui si è detto, che essa si riprenda manifestando buoni dati macroeconomici.

L’ottimismo di alcuni operatori interpreta tali dati come segnali di uscita dalla crisi salvo poi ricredersi quando tali dati sono negativi: vedi il -2,9 % del Pil statunitense registrato nel primo trimestre 2014 e diffuso il 25 giugno scorso.

Per evitare di cadere in facili ottimismi, riteniamo opportuno evidenziare che la crisi è ancora in corso e continuerà ad esserlo finché la Fed manterrà in atto politiche di stimolo monetario o la forward guidance di tassi pari a zero.

Né c’è da entusiasmarsi per il fatto che la data del 18 dicembre 2013, indicata all’inizio di questo primo paragrafo, forse potrà passare alla storia come quella di uscita dell’economia statunitense dalla crisi; potrebbe essere vero ma meglio non fidarsi visto che è ancora in corso il tapering relativo al terzo Qe e che la Fed , anche se è poco probabile, potrebbe adottare una nuova fase di Qe.

Allora come rispondiamo alla domanda posta a titolo del presente articolo?

Procediamo per gradi.

2. L’andamento di Ib e dell’inflazione come indicatori di cambiamento per una possibile uscita dalla crisi e quindi dal rischio incombente e opprimente della deflazione.

Quando l’economia USA potrà considerarsi fuori dalla crisi?

Sulla base di quanto precedentemente esposto la risposta più ovvia alla precedente domanda sarebbe: “Quando le politiche economiche di stampo keynesiano (comprendenti anche i Qe di cui si è detto) messe in atto dalla Fed e dal governo degli Stati Uniti indurranno la Fed stessa ad aumentare per la prima volta il tasso di riferimento dei fed funds”, il cui ultimo aumento risale al giugno 2006. Ma una tale risposta, pur essendo ovvia, ragionevole e immediata, è tuttavia insoddisfacente per chi sa già che, al momento del primo rialzo del tasso dei fed funds, Ib sarà già salito e pertanto desideri rilevare la ripresa dell’economia USA prima del rialzo del tasso della Fed, magari cogliendolo nell’andamento al rialzo di Ib che generalmente precede il rialzo della Fed.

Insomma tale risposta è insoddisfacente per chi volesse cogliere l’inizio dell’estuario della crisi più che la fine dello stesso.

Un’altra risposta, alternativa alla precedente, potrebbe essere: “Quando la Fed avrà annunciato la fine del tapering in corso e successivamente si sarà sottratta alla forward guidance di tassi d’interesse a breve pari a zero”.

Anche questa risposta tuttavia non è soddisfacente in quanto ci porrebbe di fronte al rischio elevato di un significativo prolungamento della forward guidance di tassi pari a zero che non ci consentirebbe di cogliere tempestivamente l’inizio della ripresa USA.

Infatti Paul Krugman, risaputamene di scuola Keynesiana, in un suo articolo pubblicato su il Sole 24 Ore del 15 sett.2013 e in un altro precedente del 29 giugno 2013 ha fortemente sostenuto che per modificare le aspettative di finanzieri e imprenditori è necessario che la Fed prometta in modo credibile che sarà irresponsabile e cioè che dall’inizio della eventuale ripresa aspetterà che l’inflazione cresca e inoltre lascerà passare molto tempo (molto più tempo che la gente si aspetta) prima di alzare il tasso di riferimento. E poiché la Fed sta già avendo un comportamento simile a quello suggerito dal Nobel Krugman, c’è da star sicuri che il tasso di riferimento dei fed funds sarà aumentato solo a ripresa inoltrata, ossia con ritardo rispetto all’avvio della ripresa stessa. Le due risposte in realtà sono quasi simili differiscono solo per l’insoddisfazione che insitamente creano.

L’insoddisfazione insita nella prima risposta invita a seguire l’andamento di Ib.

L’insoddisfazione insita nella seconda risposta invita a seguire l’andamento dell’inflazione, unica variabile, il cui aumento potrà indicare l’inizio della ripresa USA visto che, in un significativo prolungamento della forward guidance di tassi pari a zero con la Fed che tiene bassi i tassi alla breve, è molto probabile che restino bassi anche i tassi alla lunga ossia i valori di Ib , potendo succedere quindi che Ib si muova al rialzo in ritardo rispetto all’inflazione, fatto questo ampiamente sperato dalla Fed che potrebbe così stabilire tassi reali negativi (ossia un tasso di inflazione maggiore di Ib) anche nella parte lunga dei tassi, ossia dei tassi dei titoli decennali e trentennali, creando repressione finanziaria.

La repressione finanziaria infatti migliora i debiti degli stati e sfavorisce il rentier che successivamente, a fronte di un reddito negativo, dovuto ai tassi reali negativi, ricavato da titoli finanziari, potrebbe venderli per investire nell’economia reale, facendo sì salire i tassi a lunga, ossia Ib, ma comunque con ritardo rispetto alla salita dell’inflazione.

Da quanto sopra è evidente che per cogliere l’inizio dell’estuario della crisi, sarà necessario monitorare gli andamenti di Ib, dell’inflazione annua USA e del tasso reale dato dalla differenza tra Ib e il tasso di inflazione.

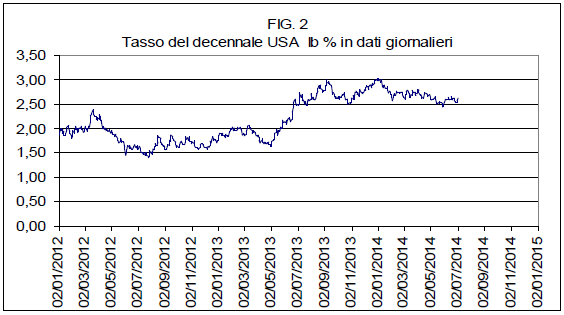

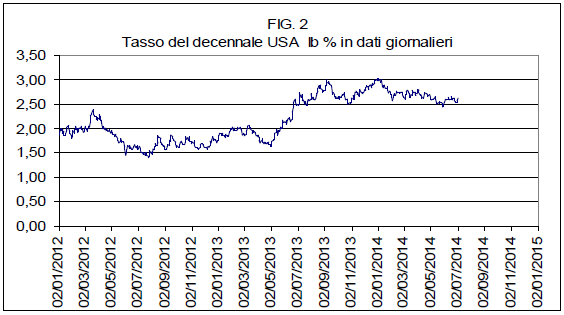

Osserviamo quindi l’andamento di Ib a partire dal 2012 così come riportato in fig. 2.

Si è deciso di partire dal 2012 perché in tale anno si sono registrati i seguenti eventi per noi significativi:

1) l’inizio del ciclo economico corrente, quello ancora in corso, che il nostro modello economico pone al lunedì 4 giugno 2012 con valore di Ib pari a 1,53 %; ciclo per il quale il nostro modello ipotizza il punto di inversione dello stesso, ipotesi questa solo momentanea, al 22 novembre 2013 (Ib pari a 2,753 %);

2) il minimo storico assoluto di Ib, pari a 1,40, valore conseguito il 24 luglio 2012, seguito due giorni dopo, il 26 luglio, dallo storico discorso a Londra di Mario Draghi “E credetemi, sarà abbastanza” col quale ha fermato la caduta dei mercati e in particolare quella dell’Euro e del tasso del Bund tedesco che pure aveva già raggiunto il suo minimo storico pari a 1,16 % il 23 luglio 2012;

3) l’inizio del terzo Qe della Fed, annunciato nel settembre 2012, avvenuto, come già detto nell’ottobre 2012 (Ib= 1,62%) e poi conclusosi a dicembre 2013 (Ib= 3,04%), seguito dal tapering in corso che al momento vede Ib oscillare tra il 2,75 e il 2,50 %.

Se la nostra ipotesi d’inversione di ciclo, posta al 22 novembre 2013, dovesse rivelarsi esatta, allora Ib dovrebbe continuare a scendere, come sta facendo da inizio gennaio 2014 e come sempre è successo durante ogni tapering della Fed e dopo ogni inversione di ciclo. È ovvio che finché il trend di Ib a partire dal suo picco di gennaio 2014 sarà fortemente discendente, ogni speranza di inizio ripresa dovrà riporsi nel cassetto, tanto più se il valore di Ib dovesse andare a rivedere il suo minimo storico, come sta invece già ora succedendo al tasso del Bund decennale tedesco che il 26 giugno 2014 ha raggiunto il valore di 1,24%, indicando quanto sia lontana anni luce ogni ipotesi di ripresa in Europa e paventando anzi il rischio che l’Europa possa trascinare in recessione anche gli Stati Uniti.

Ma, pur essendo consapevoli delle indicazioni di breve periodo che il nostro modello attualmente ci fornisce (la data, 22 novembre 2013, per l’ipotetica inversione di ciclo che si coordina con la configurazione di overshoot su Ib, materializzatasi a partire dal 31 ottobre 2013, haimè proprio dalla data della morte di mia madre, configurazione che, pur assopitasi un po’, è ancora in atto), volendo avventurarci in previsioni di medio lungo periodo, solo nei limiti di quanto il nostro modello potrebbe consentirci e solo al fine di cogliere l’inizio dell’estuario della crisi, allora diciamo di essere propensi a credere che la nostra ipotesi di inversione di ciclo sia effettivamente solo momentanea e che, o vera o sbagliata che sia (nel senso che l’evoluzione del ciclo corrente potrebbe indicare un’inversione spostata più in là nel tempo), molto probabilmente Ib nella sua discesa nel ciclo corrente non rivedrà i minimi del 2012.

In tal senso riteniamo quindi che il ciclo corrente verrà a porsi come il primo ciclo economico che dal novembre 1981 terminerà con un valore di Ib più alto di quello registrato al suo inizio (1,53%) e poniamo alla base di questa nostra opinione le seguenti tre considerazioni sugli eventi probabili che ciascuna di esse descrive:

a) Il ciclo corrente, stando al nostro modello è inserito in una località instabile di lungo periodo LILP, così come da noi definita nell’articolo “Ontologia applicata al DJIA:conseguenze”; in tale località di lungo periodo, iniziata nel luglio 2010, il nostro ciclo corrente è il terzo dopo i primi due che si sono chiusi, anch’essi, come tutti i cicli della LSLP (località stabile di lungo periodo) che ha preceduto la LILP corrente, con i due rispettivi punti, PEI, di avvicinamento all’equilibrio nei quali Ib ha manifestato sempre un valore decrescente fino a raggiungere nel PEI del secondo ciclo il valore prossimo al minimo storico pari a 1,46%, il venerdì primo giugno 2012. C’è ragione di credere che questa volta il nostro ciclo corrente possa comportarsi in modo diverso rispetto a tutti quelli (otto) che l’hanno preceduto fin dal novembre 1981? È solo questione di probabilità e, in una LILP avanzata, la probabilità che il suo ciclo corrente si chiuda con un valore di Ib più alto di quello registrato nel PEI precedente, da cui lo stesso ciclo ha avuto origine, è alta.

b) Si è venuto a creare da luglio 2012 a giugno 2014 un forte scostamento tra Ib e il tasso del Bund decennale tedesco; infatti se lo spread Ib- Bund si aggirava intorno a 0,25% nel luglio 2012 oggi tale valore si aggira intorno a 1,3% con un valore di Ib che oscilla tra 2,75 e 2,60%; spread che ovviamente indica come la marcia dell’economia USA verso l’uscita della crisi abbia acquistato sempre più velocità rispetto a quella dell’economia tedesca ed europea e che probabilmente sarà l’economia USA a trascinare fuori dalla crisi quella europea magari con Ib che durante il tapering corrente si mantenga a lungo sui livelli attuali o giù di lì senza mai scendere però sotto il valore di 2,00- 2,30% (al di sotto del quale la nostra ipotesi di inversione di ciclo riprenderebbe forza, allontanando momentaneamente l’ipotesi di ripresa) per poi, verso la fine del tapering stesso, riprendere a salire.

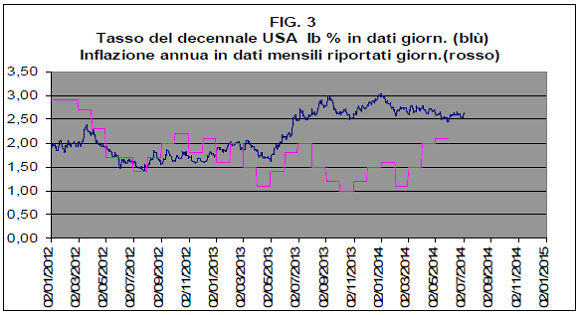

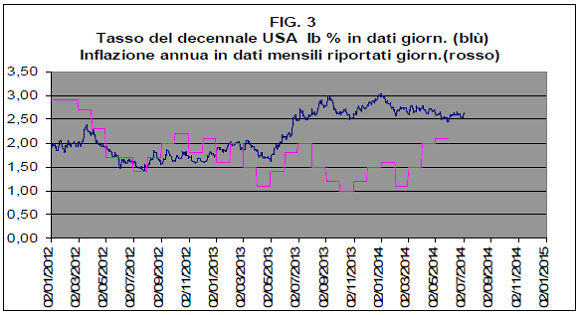

c) Negli Stati uniti l’inflazione è tornata ad aumentare e sta riducendo il tasso reale relativo a Ib con una tendenza che probabilmente renderà tale tasso negativo, come la Fed spera e come si può osservare dal grafico di fig.3 che qui segue:

3. Le condizioni di uscita dalla crisi e il rischio di overshoot su Ib

Il materializzarsi degli eventi probabili descritti nelle nostre tre considerazioni precedenti creerà le condizioni minime concomitanti indicanti l’inizio dell’estuario della crisi, condizioni che possiamo così sintetizzare:

1) Ib persistentemente maggiore del 2,30% con manifesta tendenza al rialzo nella fase finale del tapering corrente.

2) Tasso annuo di inflazione persistentemente maggiore del 2% con tendenza al rialzo.

3) Tasso reale relativo a Ib persistentemente basso o negativo.

Ma per poter raggiungere la fine dell’estuario della crisi, al pieno realizzarsi delle condizioni suddette se ne dovranno aggiungere delle altre, quali:

4) Tasso di disoccupazione persistentemente sotto il 6% e tendente a diminuire per convergere verso il tasso di inflazione.

5) Annuncio di fine tapering della Fed e subentro della BCE alla Fed nel ruolo di garante della liquidità globale nel quadro di una exit strategy condivisa tra Fed e BCE al fine di evitare bolle e ricadute dell’economia; exit strategy condivisa le cui tracce noi già riscontriamo, a parti invertite tra le due banche centrali, nella tempistica dei punti 2) e 3) riportati precedentemente nel paragrafo 2.

6) Fine della forward guidance di tassi d’interesse a breve pari a zero e uscita dalla exit strategy con il primo rialzo del tasso di riferimento dei fed funds.

Da quanto sopra si può dedurre quanto lungo e difficile possa essere il percorso di uscita dalla crisi; basti pensare al -2,9% del Pil statunitense registrato nel primo trimestre di quest’anno e diffuso il 25 giugno scorso per rendersi conto della natura degli ostacoli che possono intralciare il percorso dell’economia USA.

Ma l’ostacolo più grande secondo noi è la configurazione di overshoot su Ib, configurazione che, pur in fase di assopimento, il nostro modello attualmente segnala ancora; l’overshoot su Ib preoccupa la Fed ed era una preoccupazione anche per Keynes che nella sua Teoria generale osservava come il valore effettivo del tasso è governato dall’opinione prevalente su quello che sarà il suo valore futuro e che il tasso può fluttuare a lungo intorno al valore normale atteso, valore che può assestarsi su livelli troppo elevati per garantire la piena occupazione e il consumo.

Per la Fed il percorso di uscita dalla crisi dovrebbe finire tra circa un anno; noi abbiamo cercato di delinearne le tappe, non ci resta che sperare in una sua felice conclusione: speriamo bene. Contando di tornare sull’argomento, intanto prepariamoci a interpretare i profitti del secondo trimestre delle società americane che certamente forniranno informazioni utili sull’attuale andamento dell’economia USA.

Giacomo De Laurentis (ing.)

Polignano a Mare (BA)

5 luglio 2014