|

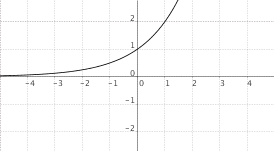

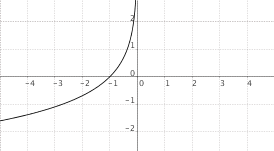

$f(x) = a^x$, $a > 1$

|

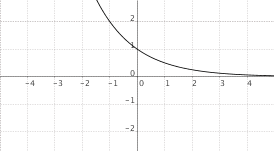

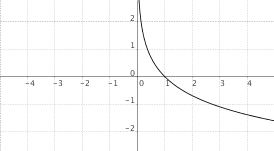

$f(x) = a^{-x}$, $a > 1$

|

|

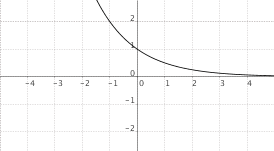

$f(x) = a^x$, $0 < a < 1$

|

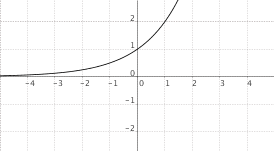

$f(x) = a^{-x}$, $0 < a < 1$

|

|

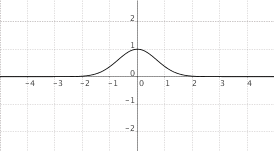

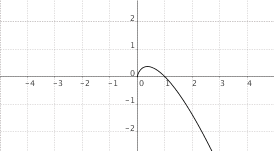

$f(x) = e^{-x^2}$

|

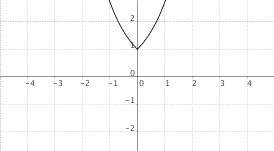

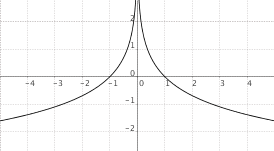

$f(x) = a^{|x|}$, $a > 1$

|

|

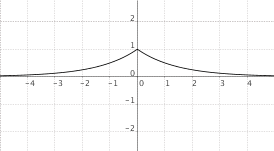

$f(x) = a^{|x|}$, $0 < a < 1$

|

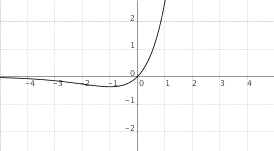

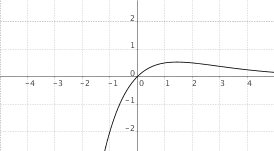

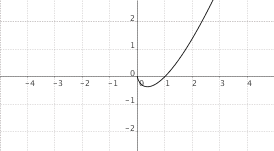

$f(x) = x cdot a^x$, $a > 1$

|

|

$f(x) = x cdot a^x$, $0 < a < 1$

|

|

Autore: Gianni Sammito

Grafici di funzioni elementari (funzioni logaritmiche)

|

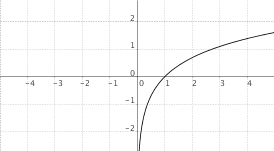

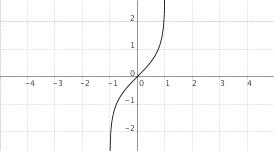

$f(x) = log_a(x)$, $a > 1$

|

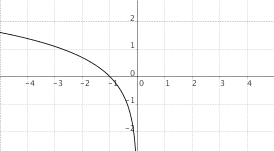

$f(x) = log_a(-x)$, $a > 1$

|

|

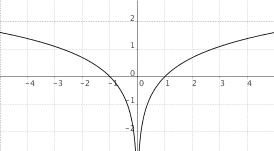

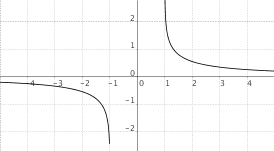

$f(x) = log_a(|x|)$, $a > 1$

|

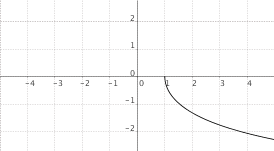

$f(x) = log_a(x)$, $0 < a < 1$

|

|

$f(x) = log_a(-x)$, $0 < a < 1$

|

$f(x) = log_a(|x|)$, $0 < a < 1$

|

|

$f(x) = x cdot log_a(x)$, $a > 1$

|

$f(x) = x cdot log_a(x)$, $0 < a < 1$

|

Grafici di funzioni elementari (funzioni goniometriche)

|

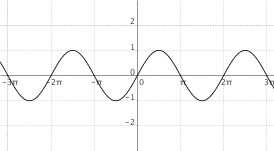

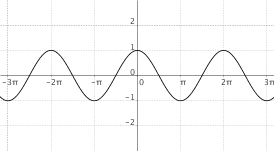

$f(x) = sin(x)$

|

$f(x) = cos(x)$

|

|

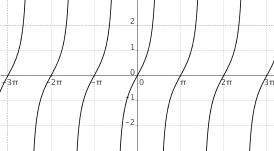

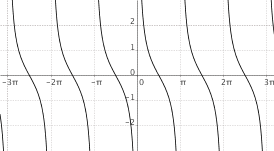

$f(x) = "tg"(x)$

|

$f(x) = "cotg"(x)$

|

|

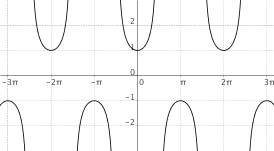

$f(x) = "sec"(x)$

|

$f(x) = "cosec"(x)$

|

|

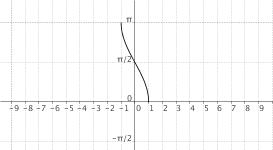

$f(x) = "arcsin"(x)$

|

$f(x) = "arccos"(x)$

|

|

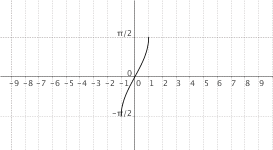

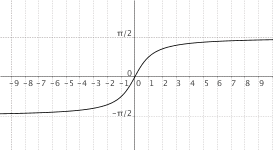

$f(x) = "arctg"(x)$

|

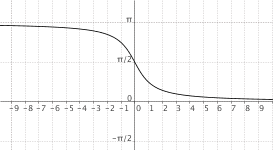

$f(x) = "arccotg"(x)$

|

|

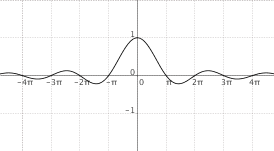

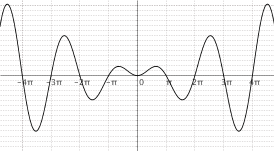

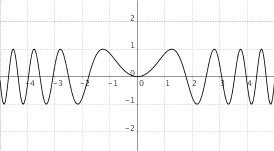

$f(x) = frac{sin(x)}{x}$

|

$f(x) = x cdot sin(x)$

|

|

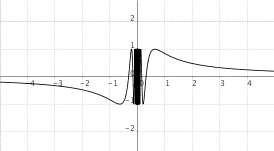

$f(x) = sin(frac{1}{x})$

|

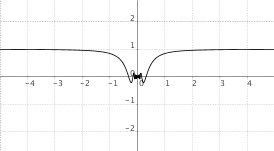

$f(x) = x cdot sin(frac{1}{x})$  |

|

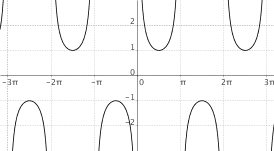

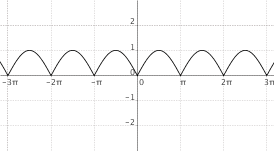

$f(x) = |sin(x)|$  |

$f(x) = sin(x^2)$  |

Grafici di funzioni elementari (funzioni iperboliche)

|

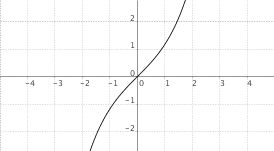

$f(x) = sinh(x)$

|

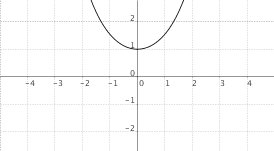

$f(x) = cosh(x)$

|

|

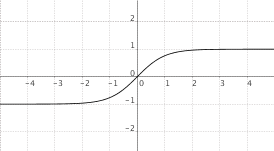

$f(x) = "tgh"(x)$

|

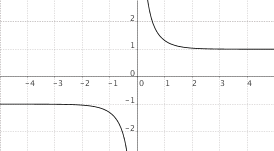

$f(x) = "cotgh"(x)$

|

|

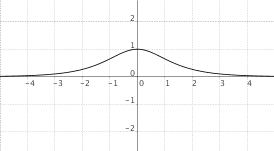

$f(x) = "sech"(x)$

|

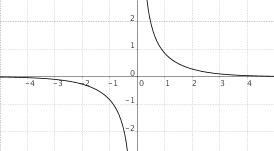

$f(x) = "cosech"(x)$

|

|

$f(x) = "settsinh"(x)$

|

$f(x) = "settcosh"(x)$

|

|

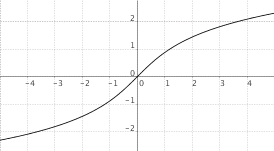

$f(x) = "setttgh"(x)$

|

$f(x) ="settcotgh"(x)$

|

Equazioni differenziali ordinarie (EDO)

EDO lineare del I ordine a coefficienti variabili

EDO lineare omogenea del II ordine a coefficienti costanti (reali)

EDO lineare omogenea di ordine $n$ a coefficienti costanti (reali)

EDO lineare completa di ordine $n$ a coefficienti costanti (reali)

EDO lineare completa di ordine $n$ a coefficienti costanti (reali)

Equazione differenziale a variabili separabili

Equazioni riconducibili a variabili separabili

Equazioni riconducibili a variabili separabili

Equazione di Bernoulli

EDO a coefficienti variabili notevoli

Trasformata di Laplace

Definizione

Proprietà della trasformata di Laplace

Tavola delle principali trasformate di Laplace

| Funzione | Trasformata |

| $\delta(t)$ (delta di Dirac) | $1$ |

| $H(t) = \{(1, \quad "se " t \ge 0),(0, \quad "se " t < 0):}$ (funzione di Heaviside) | $\frac{1}{s}$ |

| $t \cdot H(t)$ (rampa unitaria) | $\frac{1}{s^2}$ |

| $H(t-a)$ (funzione di Heaviside traslata) | $\frac{1}{s} e^{-as}$ |

| $e^{at} H(t)$ | $\frac{1}{s-a}$ |

| $t^n \cdot H(t)$ | $\frac{n!}{s^{n+1}}$ |

| $\root{n}{t} \cdot H(t)$ | $s^{-(1 + \frac{1}{n})} \Gamma(1 + \frac{1}{n})$ ($\Gamma$ indica la Gamma di Eulero) |

| $\frac{t^{n-1}}{(n-1)!} e^{at} H(t)$ (esponenziale polinomiale) | $\frac{1}{(s-a)^n}$ |

| $\sin(\omega t) H(t)$ | $\frac{\omega}{s^2 + \omega^2}$ |

| $\cos(\omega t) H(t)$ | $\frac{s}{s^" + \omega^2}$ |

| $\sinh(\omega t) H(t)$ | $\frac{\omega}{s^2 – \omega^2}$ |

| $\cosh(\omega t) H(t)$ |

$\frac{s}{s^2 – \omega^2}$ |

| $\ln(t)$ |

$-\frac{\ln(s) + \gamma}{s}$, dove $\gamma$ è la costante di Eulero-Mascheroni |

| $\frac{1}{\omega_n \sqrt{1 – \zeta^2}} e^{-\zeta \omega_n t} \sin(\omega_n \sqrt{1 – \zeta^2} t) H(t)$ | $\frac{1}{s^2 + 2 \zeta \omega_n s + \omega_n^2}$ (fattore trinomio) |

| $e^{-at} \cos(\omega t) H(t)$ | $\frac{s+a}{(s+a)^2 + \omega^2}$ |

| $e^{-at} \sin(\omega t) H(t)$ | $\frac{\omega}{(s+a)^2 + \omega^2}$ |

| $J_n(t)$ (funzione di Bessel di prima specie) | $\frac{(s + \sqrt{s^2 + 1})^{-n}}{s^2 + 1}$ |

| $I_n(t)$ (funzione di Bessel modificata di prima specie) | $\frac{(s + \sqrt{s^2 – 1})^{-n}}{s^2 – 1}$ |

Antitrasformata di Laplace

2) Fatto questo si scompone la $F(s)$ in fratti semplici, in questo modo

Trasformata zeta

Definizione

Proprietà

Trasformate zeta notevoli

| Successione |

Trasformata |

| $\delta_k^0 = \{(1, \quad "se " k = 0),(0, \quad "altrimenti"):}$ (impulso unitario) | $1$ |

| $\delta_k^1 = u_k = \{(1, \quad "se " k = 0", " 1", " 2", " \ldots),(0, \quad "altrimenti"):}$ (gradino unitario) | $\frac{z}{z-1}$ |

| $k u_k$ (rampa unitaria)$ | $\frac{z}{(z-1)^2}$ |

| $u_{k-h}$ (gradino unitario con inizio in $k=h$) | $z^{-h} \frac{z}{z-1}$ |

| $a^k u_k$ (successione esponenziale) | $\frac{z}{z-a}$ |

| $k \cdot a^k \cdot u_k$ | $\frac{a z}{(z-a)^2}$ |

| $a^k ((k),(h))$ (potenza-polinomio) | $\frac{a^h z}{(z-a)^{h+1}}$ |

| $\sin(k \theta) \cdot u_k$ (sinusoide) | $\frac{z \sin(\theta)}{z^2 – 2 z \cos(\theta) + 1}$ |

| $\cos(k \theta) \cdot u_k$ | $\frac{z^2 – z \cos(\theta)}{z^2 – 2 z \cos(\theta) + 1}$ |

Antitrasformata zeta

Serie di Fourier

Serie di Fourier in forma di esponenziali complessi

Serie di Fourier trigonometrica

Caso particolare: funzioni $2 \pi$-periodiche

Caso particolare: funzioni $2 \pi$-periodiche

Trasformata di Fourier

Definizione

Condizioni sufficienti per la trasformabilità secondo Fourier

Antitrasformata di Fourier

Antitrasformata di Fourier

Proprietà della trasformata di Fourier

Trasformate di Fourier notevoli

Trasformate di Fourier notevoli

| funzione |

trasformata |

| $1$ | $\delta(f)$ (delta di Dirac) |

| $c$ (costante) | $c \cdot \delta(f)$ |

| $u(t) = \{(1, \quad "se " t > 0),(\frac{1}{2}, \quad "se " t = 0),(0, "se " t < 0):}$ | $\frac{1}{i 2 \pi f} + \frac{\delta(f)}{2}$ |

| $t \cdot u(t)$ | $\frac{1}{(i 2 \pi f)^2} + \frac{\delta(f)}{i 4 \pi f}$ |

| $t^n \cdot u(t)$ | $\frac{n!}{(i 2 \pi f)^{n+1}} + \frac{\delta(f) \cdot n!}{2 (i 2 \pi f)^n}$ |

| $t$ | $\frac{i}{2 \pi} \frac{d}{df} \delta(f)$ |

| $|t|$ | $-\frac{1}{2 \pi^2 f^2}$ |

| $|t^n|$ ($n$ dispari) | $\frac{2 n!}{(i 2 \pi f)^{n+1}}$ |

| $"sgn"(t)$ (funzione segno) | $\frac{1}{i 2 \pi f}$ |

| $\delta(t)$ | $1$ |

| $"rect"(t) = \{(1, \quad "se " |t| < \frac{1}{2}),(\frac{1}{2}, \quad "se " |t| = \frac{1}{2}),(0, \quad "altrimenti"):}$ | $"sinc"(f) = \{(\frac{\sin(\pi f)}{\pi f}, \quad "se " f \ne 0),(1, \quad "se " f = 0):}$ |

| $"sinc"(t)$ | $"rect"(f)$ |

| $"tr"(t) = \{(1 – |t|, \quad "se " |t| < 1),(0, \quad "altrimenti"):}$ | $"sinc"^2(f)$ |

| $"sinc"^2(t)$ | $"tr"(f)$ |

| $\frac{1}{t}$ | $-i \pi "sgn"(f)$ |

| $\frac{1}{t^n}$ ($n$) | $\frac{(-i)^n \pi (2 \pi f)^{n-1} "sgn"(f)}{(n-1)!}$ |

| $\sin(2 \pi f_0 t)$ |

$\frac{\delta(f – f_0) – \delta(f + f_0)}{2 i}$ |

| $\cos(2 \pi f_0 t)$ | $\frac{\delta(f – f_0) + \delta(f + f_0)}{2}$ |

| $u(t) \cdot \sin(2 \pi f_0 t)$ |

$\frac{f_0}{2 \pi (f_0^2 – f^2)} + \frac{\delta(f – f_0) – \delta(f + f_0)}{4 i}$ |

| $u(t) \cdot \cos(2 \pi f_0 t)$ | $\frac{i f}{2 \pi (f_0^2 – f^2)} + \frac{\delta(f – f_0) + \delta(f + f_0)}{4}$ |

| $e^{-\alpha t} u(t)$ (con $\alpha > 0$) | $\frac{1}{a + i 2 \pi f}$ |

| $t \cdot e^{-\alpha t} u(t)$ (con $\alpha > 0$) |

$\frac{1}{(a + i 2 \pi f)^2}$ |

| $e^{-\alpha |t|}$ (con $\alpha > 0$) | $\frac{2 \alpha}{\alpha^2 + 4 \pi^2 f^2}$ |

| $u(t) e^{- \alpha t} \sin(2 \pi f_0 t)$ (con $\alpha > 0$) | $\frac{2 \pi f_0}{(a + i 2 \pi f)^2 + 4 \pi^2 f_0^2}$ |

| $u(t) e^{- \alpha t} \cos(2 \pi f_0 t)$ (con $\alpha > 0$) |

$\frac{a + i 2 \pi f}{(a + i 2 \pi f)^2 + 4 \pi^2 f_0^2}$ |

| $e^{- \frac{t^2}{2 T^2}}$ | $T \sqrt{2 \pi} e^{-2 \pi^2 T^2 f^2}$ |

| $"erf"(\alpha t) = \frac{2}{\sqrt{\pi}} \int_0^{\alpha t} e^{-y^2} dy$ | $\frac{e^{- (\frac{\pi f}{\alpha})^2}}{i \pi f}$ |

| $e^{2 \pi f_0 t}$ ($f_0 \in \mathbb{C}$) | $\delta(f + i f_0)$ |

| $\sinh(2 \pi f_0 t)$ | $\frac{1}{2} [\delta(f + i f_0) – \delta(f – i f_0)]$ |

| $\cosh(2 \pi f_0 t)$ | $\frac{1}{2} [\delta(f + i f_0) + \delta(f – i f_0)]$ |

Somma in $mathbb{R}^n$ e $mathbb{C}^n$, somma fra matrici, prodotto per scalare

Somma in $\mathbb{R}^n$ e in $\mathbb{C}^n$

Prodotto fra uno scalare e un vettore

Somma fra matrici

Somma fra matrici

Prodotto fra uno scalare e una matrice

Dato uno scalare $\lambda$ (cioè una costante reale o complessa) e una matrice $A$ di ordine $m \times n$, a coefficienti reali o complessi, il prodotto $\lambda \cdot A$ è definito come la matrice di ordine $m \times n$ la cui componente di posto $ij$ è data dal prodotto fra $\lambda$ e la componente di posto $ij$ di $A$. In formule

Spazi vettoriali

Definizione e proprietà

Prodotto scalare

Definizione e proprietà

Prodotto scalare canonico in $\mathbb{C}^n$

Prodotto scalare canonico in $\mathbb{R}^n$

Norma

Definizione e proprietà

Norme indotte da un prodotto scalare

Norme indotte da un prodotto scalare

Esempi di norme

Esempi di norme

Prodotto fra matrici

Caso particolare: prodotto fra vettori

Determinante di una matrice

e 0$, e $B$ è l’inversa di $A$, cioè tale che $AB = I$, allora

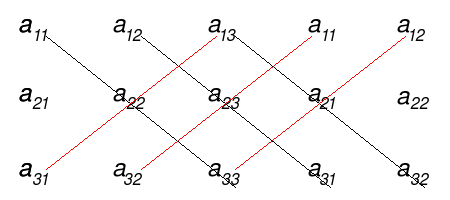

Matrici $3 imes 3$: metodo di Sarrus

Continuità di funzione definita su intervalli

La funzione è continua in $\mathbb{R} \setminus \{0, \frac{\pi}{2}\}$ indipendentemente dai valori di $a,b$, perché ottenuta per composizione di funzioni continue. Si devono quindi determinare $a, b \in \mathbb{R}$ affinché la funzione sia continua pure in $0$ e $\frac{\pi}{2}$.

Proprietà topologiche in $mathbb{R}^2$

Sia $D \subset \mathbb{R}^2$ il dominio di definizione della funzione

$f(x,y) = \sqrt{x^2 – 4} \cdot \log(36 – 4x^2 – 9y^2)$

Disegnarlo, determinare la frontiera e stabilire se $D$ è aperto, chiuso, limitato, compatto, e da quante componenti connesse è composto.

Una radice quadrata è definita quando il radicando è non negativo, un logaritmo invece ha senso se l'argomento è positivo, pertanto il dominio della funzione si può trovare risolvendo il seguente sistema

$\{(x^2 – 4 \ge 0),(36 – 4x^2 – 9y^2 > 0):} = \{(x \le -2 \quad \vee \quad x \ge 2),(\frac{x^2}{9} + \frac{y^2}{4} < 1):}$

Quindi $D = \{(x,y) \in \mathbb{R}^2: x^2 – 4 \ge 0, \frac{x^2}{9} + \frac{y^2}{4} < 1\}$

La frontiera dell'insieme è

$\partial D = \{(-2,y) \in \mathbb{R}^2: – \sqrt{\frac{28}{9}} \le y \le \sqrt{\frac{28}{9}}\} \cup \{(2,y) \in \mathbb{R}^2: – \sqrt{\frac{28}{9}} \le y \le \sqrt{\frac{28}{9}}\} \cup \{(x,y) \in \mathbb{R}^2: \frac{x^2}{9} + \frac{y^2}{4} = 1, x \le -2\} \cup \{(x,y) \in \mathbb{R}^2: \frac{x^2}{9} + \frac{y^2}{4} = 1, x \ge 2\}$

Dato che $\partial D \cap D \ne \emptyset$, e che la frontiera di $D$ non è interamente contenuta in $D$, l'insieme non è aperto né chiuso.

Il dominio $D$ è un insieme limitato, esiste infatti un intorno sferico aperto dell'origine (ad esempio di raggio $10$) che lo contenga propriamente.

Infine $D$ non è connesso per archi, ma possiede due componenti connesse.

FINE

Inversa di una matrice

Se $A$ è una matrice quadrata di ordine $n \times n$, ed esiste una matrice $B$ tale che $AB = I$, si dice che $B$ è l’inversa di $A$, e si scrive $B = A^{-1}$.

Una matrice quadrata $A$ ammette un’inversa se e solo se $\det(A) \ne 0$, e in tal caso si dice invertibile (una matrice con determinante nullo si dice singolare). Quando una matrice ammette un’inversa, essa è unica.

Calcolo dell’inversa

Studiare al convergenza semplice e assoluta $sum_{n=1}^{+infty} (-1)^n log(1 + frac{1}{n})$

Studiare al convergenza semplice e assoluta della seguente serie a termini di segno alterno

$\sum_{n=1}^{+\infty} (-1)^n \log(1 + \frac{1}{n})$

Dato che $1 + \frac{1}{n} > 1$ $\forall n \in \mathbb{N} \setminus \{0\}$ allora $\log(1 + \frac{1}{n}) > 0$ $\forall n \in \mathbb{N} \setminus \{0\}$, pertanto la serie è effettivamente a termini di segno alterno.

Visto che

$1 + \frac{1}{n + 1} < 1 + \frac{1}{n}$ $\forall n \in \mathbb{N} \setminus \{0\}$

allora la successione $\{1 + \frac{1}{n}\}_{n \ge 1}$ è monotona decrescente, pertanto anche la successione $\{\log(1 + \frac{1}{n})\}_{n \ge 1}$ è monotona decrescente, visto che il logaritmo in base $e$ è una funzione monotona crescente. Pertanto la serie proposta converge semplicemente per il criterio di Leibniz.

Per studiare la convergenza assoluta occorre considerare la serie

$\sum_{n=1}^{+\infty} |(-1)^n \log(1 + \frac{1}{n})| = \sum_{n=1}^{+\infty} |\log(1 + \frac{1}{n})| = \sum_{n=1}^{+\infty} \log(1 + \frac{1}{n})$

per quanto detto prima sulla positività di $\log(1 + \frac{1}{n})$ quando $n=1,2,\ldots$.

Osservando che

$\lim_{n \to +\infty} \frac{\log(1 + \frac{1}{n})}{\frac{1}{n}} = 1$

si nota che

$\log(1 + \frac{1}{n}) \sim \frac{1}{n}$

Ma

$\sum_{n=1}^{+\infty} \frac{1}{n}$

diverge, perché è una serie armonica con esponente pari a $1$, pertanto la serie proposta non converge assolutamente per il criterio del confronto asintotico.

FINE

Studiare il carattere della seguente serie a termini positivi$sum_{n=1}^{+infty} {3^n}/((n-1)!)$.

Studiare il carattere della seguente serie a termini positivi

$\sum_{n=1}^{+\infty} \frac{3^n}{(n-1)!}$

Dato che

$\lim_{n \to +\infty} \frac{\frac{3^{n+1}}{n!}}{\frac{3^n}{(n-1)!}} = \lim_{n \to +\infty} \frac{3^{n+1}}{n!} \cdot \frac{(n-1)!}{3^n} = \lim_{n \to +\infty} \frac{3}{n} = 0 < 1$

la serie proposta converge per il criterio del rapporto.

FINE

Max, min, sup, inf per sottoinsiemi di $mathbb{R}$

Stabilire se il seguente insieme è limitato superiormente, inferiormente. Determinare (se esistono) l'estremo superiore, l'estremo inferiore, il massimo e il minimo assoluto.

$\{x \in \mathbb{R}: \sqrt{x^2 + x – 6} >1\}$

Affinché la radice abbia senso, è necessario che il radicando sia non negativo:

$x^2 + x – 6 \ge 0$ (1)

Le soluzioni dell'equazione associata sono

$x_{1,2} = \frac{-1 \pm \sqrt{1 + 24}}{2} = \frac{-1 \pm 5}{2}$

$x_1 = -3 \quad x_2 = 2$

pertanto la (1) è soddisfatta per

$x \le -3 \quad \vee \quad x \ge 2$ (3)

La diseuquazione

$\sqrt{x^2 + x – 6} \ge 1$

è soddisfatta se vale (3) e se

$x^2 + x – 6 \ge 1$ (4)

Le soluzioni dell'equazione associata sono

$x_{1,2} = \frac{-1 \pm \sqrt{1+28}}{2} = \frac{-1 \pm \sqrt{29}}{2}$

pertanto la (4) è soddisfatta per

$x < \frac{-1 – \sqrt{29}}{2} \quad \vee \quad x > \frac{-1 + \sqrt{29}}{2}$

quindi, tenendo conto anche di (3), l'insiemee iniziale si può riscrivere come

$\{x \in \mathbb{R}: x < \frac{-1 – \sqrt{29}}{2} \quad \vee \quad x > \frac{-1 + \sqrt{29}}{2}\} = ]-\infty, \frac{-1 – \sqrt{29}}{2}[ \quad \cup \quad ]\frac{-1 + \sqrt{29}}{2}, +\infty[$

Pertanto l'insieme è illimitato sia superiormente che inferiormente. Non ammettené minimo assoluto né massimo assoluto, l'estremo inferiore e superiore coincidono rispettivamente con $-\infty$ e $+\infty$.

FINE

Autovalori di una matrice

Calcolo degli autovalori

Autovettori e autospazi

Definizione

Calcolo degli autovettori

Calcolo degli autovettori

Diagonalizzazione

Definizione

Calcolo di $\Lambda$ e $T$

Potenza di una matrice

Definizione

Potenza di una matrice diagonalizzabile

$frac{x^2}{a^2} + frac{y^2}{b^2} = 1$

Calcolare l’area dell’ellisse avente equazione cartesiana

$\frac{x^2}{a^2} + \frac{y^2}{b^2} = 1$

L’area richiesta equivale a

$\int \int_{A} dxdy$

dove

$A = \{(x,y) \in \mathbb{R}^2: \frac{x^2}{a^2} + \frac{y^2}{b^2} \le 1\}$

Conviene passare in coordinate polari, ponendo

$\{(x = a \rho \cos(\theta)),(y = b \rho \sin(\theta)):}$

con $\rho \in [0, +\infty)$ e $\theta \in [0, 2 \pi]$. La matrice Jacobiana associata alla trasformazione è

$J(\rho, \theta) = [(\frac{\partial}{\partial \rho} x, \frac{\partial}{\partial \theta} x),(\frac{\partial}{\partial \rho} y, \frac{\partial}{\partial \theta} y)] = [(a \cos(\theta), -a \rho \sin(\theta)),(b \sin(\theta), b \rho \cos(\theta))]$

Il determinante della matrice Jacobiana vale

$\det(J(\rho, \theta)) = ab \rho \cos^2(\theta) + ab \rho \sin^2(\theta) = ab \rho$

pertanto

$dxdy = |ab \rho| d \rho d \theta = ab \rho d \rho d \theta$

Imponendo la condizione $\frac{x^2}{a^2} + \frac{y^2}{b^2} \le 1$ si ottiene

$\rho^2 \cos^2(\theta) + \rho^2 \sin^2(\theta) \le 1 \implies \rho \in [0, 1]$

Pertanto l’area dell’ellisse vale

$\int_{0}^{2 \pi} \int_{0}^{1} ab \rho d \rho d \theta = \frac{ab}{2} \int_{0}^{2 \pi} [\rho^2]_{0}^{1} d \theta = \frac{ab}{2} \int_{0}^{2 \pi} d \theta = \frac{ab}{2} \cdot 2 \pi = ab \pi$

FINE

Esponenziale di una matrice

Definizione

Esponenziale di una matrice diagonalizzabile

Rettangolo di area massima

Il semiperimetro del rettangolo vale $p$, quindi chiamando con $x$ la base ($0 \le x \le p$) si deduce che l'altezza vale $p – x$. Da notare che se $x = 0 \vee x = p$ il rettangolo degenera in un segmento. La funzione che rappresenta l'area al variare di $x$ è

Spazi di probabilità

Definizione

Caso particolare: equiprobabilità

Proprietà

Studio della funzione $f(x) = |x^2 – 2x| e^x$

Studiare il grafico della seguente funzione reale di variabile reale

$f(x) = |x^2 – 2x| e^x$

La $f$ è data dalla composizione di funzioni continue, pertanto è continua nel suo dominio. Dato che $f(x) \ne f(-x)$ e $f(x) \ne -f(-x)$ la funzione non è né pari né dispari.

$x=0 \implies f(0) = 0$

$f(x) = 0 \implies x = 0 \vee x=2$

pertanto i punti di intersezione fra il grafico della funzione e gli assi cartesiani sono $(0,0)$ e $(2,0)$. Visto che l’esponenziale e il valore assoluto sono non negativi, la funzione è non negativa nel suo dominio.

$\lim_{x \to +\infty} f(x) = \lim_{x \to +\infty} (x^2 – 2x) e^x = \lim_{x \to +\infty} x(x-2) e^x = +\infty$

$\lim_{x \to +\infty} \frac{f(x)}{x} = \lim_{x \to +\infty} \frac{x^2 – 2x}{x} e^x = \lim_{x \to +\infty} (x-2) e^x = +\infty$

pertanto, per $x \to +\infty$, non ci sono asintoti orizzontali né obliqui.

$\lim_{x \to -\infty} f(x) = \lim_{x \to -\infty} \frac{x^2 – 2x}{e^{-x}}$

Applicando due volte il teorema di de l’Hopital si ottiene

$\lim_{x \to -\infty} \frac{2x-2}{-e^{-x}} = \lim_{x \to -\infty} \frac{2}{e^{-x}} = 0$

pertanto la retta di equazione $y=0$ è un asintoto orizzontale sinistro per il grafico della funzione in questione. La derivata prima vale

$f'(x) = \{(e^x (x^2 – 2), "se " x < 0 \vee x > 2),(e^x (2 – x^2), "se " 0 < x < 2):}$

$\lim_{x \to 0^{-}} f'(x) = \lim_{x \to 0^{-}} e^x (x^2 – 2) = -2$

$\lim_{x \to 0^{+}} f'(x) = \lim_{x \to 0^{+}} e^x (2 – x^2) = 2$

Pertanto in $0$ c’è un punto angoloso, quindi $(0,0)$ è un punto di non derivabilità.

$\lim_{x \to 2^{-}} f'(x) = \lim_{x \to 2^{-}} e^x (2 – x^2) = -2 e^2$

$\lim_{x \to 2^{+}} f'(x) = \lim_{x \to 2^{+}} e^x (x^2 -2) = 2 e^2$

Anche in $2$ c’è un punto angoloso, pertanto anche $(2,0)$ è un punto di non derivabilità. La derivata prima si azzera in $x = \pm \sqrt{2}$. Per determinare il segno della derivata prima occorre studiare $f'(x) \ge 0$, che equivale a

$\{(x^2 – 2 \ge 0),(x < 0 \vee x > 2):} \quad \vee \quad \{(2 – x^2 \ge 0),(0 < x <2 ):} \implies (x < -\sqrt{2} \vee x > 2) \vee (0 < x < \sqrt{2})$

Dallo studio del segno della derivata prima si deduce che in $x=0$ e $x=2$ ci sono dei minimi, mentre in $x=\pm \sqrt{2}$ ci sono dei massimi. La derivata seconda vale

$f”(x) = \{(e^x (x^2 + 2x – 2), "se " x < 0 \vee x > 2),(e^x (2 – 2x – x^2), "se " 0 < x < 2):}$

La derivata seconda si azzera per

$\{(x^2 + 2x – 2=0),(x < 0 \vee x > 2):} \quad \vee \quad \{(2 – 2x – x^2 = 0),(0 < x < 2):}$

ovvero per $x=1 \vee x = -3$. Il segno della derivata secodna viene determinato studianto $f”(x) \ge 0$, ovvero

$\{(x^2 + 2x – 2 \ge 0),(x < 0 \vee x > 2):} \quad \vee \quad \{(2 – 2x – x^2 \ge 0),(0 < x < 2):}$

che equivale a

$\{(x < -3 \vee x > 1),(x < 0 \vee x > 2):} \quad \vee \quad \{(-3 < x < 1),(0 < x < 2):}$

Quindi la funzione è convessa se $(x < -3 \vee x > 2) \vee (0 < x < 1)$, concava altrimenti. Questo è il grafico della funzione

Quindi l’immagine della funzione è $\{x \in \mathbb{R}: x \ge 0\}$.

FINE

Probabilità condizionale e indipendenza

Definizione

Teorema di Bayes

Teorema di Bayes

Eventi indipendenti

$f(x) = e^x root{3}{x^2}$

Studiare il grafico della seguente funzione reale di variabile reale

$f(x) = e^x \root{3}{x^2}$

Il dominio massimale della funzione è $\mathbb{R}$, dato che un esponenziale è definito laddove è definito l’esponente, e una radice di indice dispari è definita laddove è definito il radicando. La $f$ è data dalla composizione di funzioni continue, pertanto nel suo dominio è continua.

La funzione in questione non è né pari né dispari, infatti $f(-x) \ne f(x)$ e $f(-x) \ne -f(x)$.

$x = 0 \implies f(0) = 0$

$f(x) = 0 \implies x = 0$

Pertanto il grafico della funzione interseca gli assi cartesiani solo nel punto $(0,0)$. La funzione è positiva (o al più uguale a zero) per:

$f(x) \ge 0 \implies e^x \root{3}{x^2} \ge 0 \implies \root{3}{x^2} \ge 0 \implies x^2 \ge 0 \forall x \in \mathbb{R}$

Pertanto la $f$ è non negativa in tutto il suo dominio.

$\lim_{x \to +\infty} e^x \root{3}{x^2} = +\infty$

$\lim_{x \to -\infty} e^x \root{3}{x^2} = \lim_{x \to -\infty} \frac{\root{3}{x^2}}{e^{-x}}$

Applicando il teorema di de l’Hopital per risolvere quest’ultimo limite si ottiene

$\lim_{x \to -\infty} \frac{2}{3} \frac{e^x}{\root{3}{x}} = 0$

Pertanto la retta di equazione $y=0$ è un asintoto orizzontale sinistro, non si sono invece asintoti orizzontali destri. Si può quindi cercare un eventuale asintoto obliquo destro

$\lim_{x \to +\infty} \frac{e^x \root{x}{x^2}}{x} = \lim_{x \to +\infty} \frac{e^x}{\root{3}{x}}$

Applicando il teorema di de l’Hopital si ottiene

$\lim_{x \to +\infty} 3 e^x \root{3}{x^2} = +\infty$

quindi non ci sono asintoti obliqui. La derivata vale

$f'(x) = e^x \root{3}{x^2} + e^x \frac{2}{3 \root{3}{x}} = e^x (\root{3}{x^2} + \frac{2}{3 \root{3}{x}})$

La derivata prima calcolata in $x=0$ vale

$\lim_{h \to 0} \frac{f(0+h) – f(0)}{h} = \lim_{h \to 0} \frac{e^h \root{3}{h^2}}{h} = \lim_{h \to 0} \frac{e^h}{\root{3}{h}}$

Dato che

$\lim_{h \to 0^+} \frac{e^h}{\root{3}{h}} = +\infty$

$\lim_{h \to 0^-} \frac{e^h}{\root{3}{h}} = -\infty$

si deduce che in $x=0$ c’è una cuspide, pertanto $(0,0)$ non è un punto di derivabilità. La derivata prima si annulla per

$f'(x) = 0 \implies \root{3}{x^2} = -\frac{2}{3 \root{3}{x}} = x = -\frac{2}{3}$

Dallo studio del segno della derivata prima, si nota che la funzione è crescente per $x \in (-\infty, -\frac{2}{3}) \cup (0, +\infty)$, mentre è decrescente per $x \in (-\frac{2}{3}, 0)$. Pertanto in $x = -\frac{2}{3}$ c’è un massimo relativo. La derivata seconda invece vale

$f”(x) = e^x (\root{3}{x^2} + \frac{2}{3 \root{3}{x}}) + e^x (\frac{2}{3 \root{3}{x}} + \frac{2}{3} (-\frac{1}{3}) \frac{1}{\root{3}{x^4}}) = e^x (\frac{9x^2 + 12x – 2}{9 \root{3}{x^4}})$

La derivata seconda si annulla per

$9x^2 + 12x – 2 = 0 \implies x_{1,2} = \frac{-6 \pm \sqrt{36+18}}{9}$

da cui

$x_1 = \frac{-2-\sqrt{6}}{3} \quad x_2 = \frac{-2+\sqrt{6}}{3}$

Pertanto $x_1$ e $x_2$ sono due punti di flesso a tangente obliqua. Dato che il denominatore della derivata seconda è sempre positivo, si nota che la funzione è concava per $x \in (\frac{-2-\sqrt{6}}{3}, 0) \cup (0, \frac{-2+\sqrt{6}}{3})$ ed è invece convessa per $x \in (-\infty, \frac{-2-\sqrt{6}}{3}) \cup (\frac{-2+\sqrt{6}}{3}, +\infty)$.

Questo è il grafico della funzione

Dunque la funzione ha un minimo assoluto in $(0,0)$, e l’immagine è

$\{x \in \mathbb{R}: x \ge 0\}$

FINE

Studio di funzione esponenziale $f(x) = x e^{-frac{1}{x}}$

Studiare il grafico della seguente funzione reale di variabile reale

$f(x) = x e^{-\frac{1}{x}}$

Il prodotto fra due termini è definito laddove sono definiti i due fattori, allo stesso modo un esponenziale è definito laddove è definito l’esponente, pertanto il dominio massimale di questa funzione è

$\{x \in \mathbb{R}: x \ne 0\}$

Dato che $f(x) \ne f(-x)$ e allo stesso tempo $f(x) \ne -f(-x)$ la funzione non è né pari né dispari. Visto che $f$ è data dalla composizione di funzioni continue, allora nel suo dominio è continua.

$f(x) = o \quad \implies \quad x=0$, considerando che tale punto non appartiene al dominio, si deduce che non ci sono intersezioni fra il grafico della funzione e gli assi cartesiani.

$e^{-\frac{1}{x}} > 0 \quad \forall x \in \mathbb{R} \setminus \{0\}$

pertanto la funzione è positiva se $x>0$ e negativa se $x < 0$.

$\lim_{x \to 0^{+}}x e^{-\frac{1}{x}} = 0 \cdot e^{-\infty} = 0$

$\lim_{x \to 0^{-}} = x e^{-\frac{1}{x}} = \lim_{x \to 0^{-}} \frac{e^{-\frac{1}{x}}}{\frac{1}{x}}$

Sfruttando il teorema di de l’Hopital si ottiene

$\lim_{x \to 0^{-}} \frac{e^{-\frac{1}{x}}}{\frac{1}{x}} = \lim_{x \to 0^{-}} \frac{e^{-\frac{1}{x}} \frac{1}{x^2}}{\frac{1}{x^2}} = \lim_{x \to 0^{-}} e^{-\frac{1}{x}} = -\infty$

Pertanto il grafico della funzione ammette come asintoto verticale sinistro la retta di equazione $x=0$.

$\lim_{x \to +\infty} x e^{-\frac{1}{x}} = +\infty$

$\lim_{x \to -\infty} x e^{-\frac{1}{x}} = -\infty$

quindi non ci sono asintoti orizzontali.

$m = \lim_{x \to \pm \infty} \frac{x e^{-\frac{1}{x}}}{x} = 1$

$q = \lim_{x \to \pm \infty} x e^{-\frac{1}{x}} – x = \lim_{x \to \pm \infty} x (e^{-\frac{1}{x}} – 1) = \lim_{x \to \pm \infty} – \frac{e^{-\frac{1}{x}} – 1}{-\frac{1}{x}} = -1$

dove all’ultimo passaggio è stato sfruttato il limite notevole

$\lim_{t \to 0} \frac{e^t – 1}{t} = 1$

Dai calcoli precedenti si nota che la funzione ammette un asintoto obliquo di equazione $y = x – 1$.

La derivata priam dela funzione vale

$f'(x) = e^{-\frac{1}{x}} + x e^{-\frac{1}{x}} \cdot \frac{1}{x^2} = e^{-\frac{1}{x}} (1 + \frac{1}{x})$

La $f$ è data dalla composizione continue e derivabili, pertanto nel suo dominio è continua e derivabile.

$f'(x) = o \implies 1 + \frac{1}{x} = 0 \implies x = -1$

$f'(x) > 0 \implies 1 + \frac{1}{x} > 0 \implies x < -1$

Dato che in $-1$ la funzione passa da essere crescente a decrescente, considerando che $f(-1) = -e$, si deduce che il punto $(-1, -e)$ è un minimo. Visto che $-e < -1 -1$ si nota che il minimo si trova sotto all’asintoto obliquo, ovvero nella parte di piano $y \le x – 1$.

La derivata seconda della funzione vale

$f”(x) = e^{-\frac{1}{x}} \frac{1}{x^2} + (-\frac{1}{x^2}) e^{-\frac{1}{x}} + \frac{1}{x^3} e^{-\frac{1}{x}} = \frac{1}{x^3} e^{-\frac{1}{x}}$

La derivata seconda non si annulla mai, pertanto non ci sono punti di flesso a tangente obliqua. Dal segno della derivata seconda si nota che la funzione è concava per $x < 0$ e convessa per $x > 0$. Dai calcoli svolti si può concludere che non ci sono intersezioni fra il grafico della funzione e l’asintoto obliquo.

L’immagine della funzione coincide con l’insieme

$(-\infty, -e] \cup (0, +\infty)$

Questo è il grafico della funzione

FINE

Variabili aleatorie discrete scalari

Definizione

Proprietà

Densità di probabilità discreta

Densità di probabilità discrete notevoli

Legge binomiale $B(n, p)$ ($n \in \mathbb{N}$, $p \in [0,1]$)

Densità ipergeometrica

Densità geometrica di parametro $p$ ($p \in [0,1]$)

Densità di Poisson ($\lambda \in \mathbb{R}^+$)

Densità discreta uniforme ($A$ è un insieme non vuoto con cardinalità finita)

Variabili aleatorie discrete vettoriali

Definizione

Densità di probabilità congiunta (discreta)

Densità di probabilità marginali

Variabili aleatorie indipendenti

Variabili aleatorie indipendenti

Valore atteso, varianza, covarianza (caso discreto)

Valore atteso

Varianza

Covarianza

Matrice di covarianza

Matrice di covarianza

Variabili aleatorie continue

Definizione

Proprietà

Funzione di distribuzione di probabilità

Funzione di densità di probabilità

Densità di probabilità continue notevoli

Densità di probabilità uniforme

Densità di probabilità esponenziale ($\lambda \in \mathbb{R}^+$)

Densità di probabilità normale (o gaussiana)

Variabili aleatorie continue vettoriali

Definizione

Funzione di distribuzione di probabilità congiunta

Funzioni di distribuzione marginali

Funzione di densità di probabilità congiunta

Funzioni di densità di probabilità marginali

Funzioni di densità di probabilità marginali

Indipendenza e densità condizionali

Definizione

Densità condizionali

Valore atteso, varianza, covarianza (caso continuo)

Valore atteso

Varianza

Covarianza

Matrice di covarianza

Matrice di covarianza

Valore atteso condizionale